人工智能领域有个“莫拉维克悖论”(Moravec’s Paradox):难的问题简单,简单的问题难。汉斯·莫拉维克:“与一般的观点相反,要让电脑如成人般地下棋相对容易,但是要让电脑有如一岁小孩般的感知和行动能力却是相当困难甚至是不可能的。”尽管人工智能可以在围棋上战胜最优秀的人类选手、精确地诊断癌症、流利地写文章/程序代码,数据分析师、翻译、经纪人、作家/画家/作曲家、程序员都要小心他们的位置被取代,但是园丁、接待员和厨师近几年不用担心他们的岗位。

假设在莫拉维克预言的智能机器取代人类的2040年,一家酒店雇用了一个加持了GPT-13(具身智能新成果机器人接入大模型),有全面的多模态感官能力(听说、视觉、触觉等)及机械灵巧性,懂200种语言、武力值为99的机器人保安,让我们看看这个机器人可能遇见的情况:一只小狗尖叫着跑进大堂,喝醉的流浪汉骚扰前台,一位顾客突然中暑,蒙面劫匪持枪闯入,旁边是戴面具拿水枪的孩子……它该如何适当的处理这些不同的对象,以确保酒店的安全和客户的满意度?

2.2.1.5.1 AIGCs(AI Generated Commonsense)

AI必须要能够学习、使用背景知识/常识(Commonsense),才能够在这样的复杂环境中知道如何随机应变。下一个AIGC(Artificial Intelligence Generated Content)是AIGCs:AI生成常识。

《测算与判断:人工智能的终极未来》第三章 失败:老派人工智能的根本局限性

现实本身异常丰富。围绕所谓的现实,任何本体论的解析只提供部分信息。通过抽象化或理想化的表征、描述、模型等方式解释、图示和过滤世界,概念性的“画面”会对某些方面进行强调或特别指出,而对其他方面则是暗示或弱化(甚至是扭曲),并忽略或抽离现实世界潜在的无限丰富性。人工智能面临的问题是,为了在现实世界中发挥作用,它需要能够处理实际意义上的现实,而不是我们所认为的现实,准确地讲,不是我们的思想或语言所表征的现实。

人工智能需要解释对象、属性和关系,并以此来解释各种造物发现世界可理解的能力,而不能预设对象、属性和关系。开发适当的注记能力不仅能够“吸收我们感官所感知到的东西”(这远远不够),而且能够发展出一个对存在于这个世界而言负责任且可靠的完整的集成图景。第一代人工智能的本体论假定、对注记的细微差别视而不见,以及对世界丰富程度的认识不足,是常识方面的表现令人失望的主要原因。

2.2.1.5.2 如何学习常识

常知类似于语言,是不能被理性主义的形式化理论所模拟的。人们在使用语言时,既不是通过严格的规则实现语言的运用,也不是通过严格的规则来学习语言(当然也就谈不上对学习语言的智能活动过程形式化了)。人类对语言的使用往往在语言的灵活应用中找到了语言的美感。AI如何能够学习、使用常识,需要参考ChatGPT如何能够学习、使用语言的(应该不是专家系统、知识图谱的逻辑主义技术路线)。

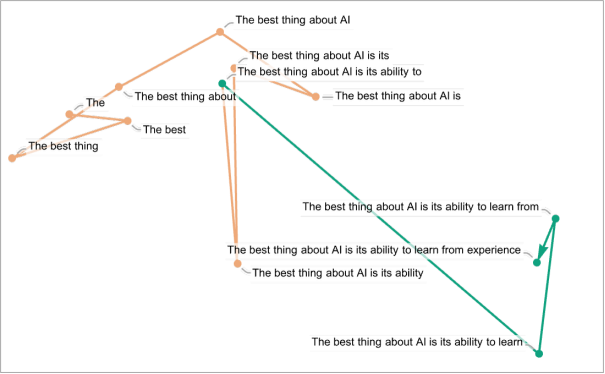

通过语言模型及其训练过程,ChatGPT“发现”了语法规则这些“语言规律”并很擅长遵循它们。同时能够实现“语义运动定律”——输出有意义的文本,定义或至少约束着语言特征空间中的点在保持“有意义性”的同时如何移动。通过查看大型文本语料库可以得到每个单词的常见程度的估计,ChatGPT 根据概率来选择生成下一个词。ChatGPT只是从其积累的“常识统计”中提取出一些“连贯的文本线索”。在ChatGPT内部,任何一段文本实际上都由一组数字表示,可以看作是某种“语言特征空间”中的一系列点的坐标。当ChatGPT继续一段文本时,相当于在语言特征空间中描绘出一条轨迹。

ChatGPT的底层人工神经网络结构最终是基于对大脑的理想化建模的,能够成功地“捕捉到”人类语言及其背后的思维的本质。语言的丰富性和它所能谈论的事物可以被封装在这样一个有限的系统中。很可能当我们学习和使用常识时,会采用非常相似的方法,例如构成Commonsense的向量空间,从其积累的大量“三维活动统计”中提取出一些“连贯的常识线索”。通过LCM(Large Commonsense Model,大型常识模型)及其训练过程,发现常识的规则及内部蕴含的意义。

2.2.1.5.3 什么时间可以实现

对机器人来说,简单的动作都需要极为复杂的机械控制系统来实现。而现实生活中常见的简单任务,把流程分解成每一个动作,并且要做到“不走形”,“容易”问题层层累加,难度是指数级递增的,是类似于从井字棋到围棋的搜索空间能力要求的提升,需要在图像嵌入设计方法、搜索方法(策略矩阵、价值矩阵)、学习方法(工程技术)、数据来源等方面的根本性的进步。

算力的发展、互联网数据的累积带来这一次(AlphaGo、GPT)的AI浪潮,我们可以在不考虑其他的技术、模型发展/要求,只从算力要求这个基本方面估算一下AIGCs出现的时间。

几个一般性假设:

0.1、假设通过物联网能够积累起丰富的、有质量的常识数据(主要是视频及人体生物信息);

0.2、假设图像/音频/视频嵌入向量空间与文本嵌入向量空间采用相似的算法及模型(视觉大模型的两条出路,向量数据库),且AIGCs的搜索算法没有质的发展/变化(统一智能体的基础模型 Towards A Unified Agent with Foundation Models);

0.3、假设机器的灵巧性、机械适应性等方面得到大幅度的发展能够支撑AIGCs;

0.4、假设摩尔定律(每1.5到2年的时间计算能力增长一倍)在未来几十年内仍然有效。

关于算力的假设:

1.1、英语大约有5 万个左右的常用词,假设现实中不同品类对象的种类及其属性的数量对计算复杂度提升一个数量级;

1.2、常识是一个在三维空间发生、发展的,有一定时间范围的过程。图像数据的维度和复杂度都比文本数据高,图像嵌入的计算量要远远大于词嵌入的计算量。假设三维空间的精细运动加上时间过程维度,对计算复杂度提升两个数量级;

1.3、其他未知因素(如对大模型幻觉的控制等)对计算复杂度提升一个数量级;

综上,计算复杂度的提升为:10^4 ≈ 2^14。

AIGCs会在未来14×(1.5~2) ≈ 20~30年左右出现。

Consciousness in Artificial Intelligence: Insights from the Science of Consciousness

https://arxiv.org/abs/2308.08708

本文展示并举例说明了一种严格且以实证为基础的人工智能意识检验方法:根据最受支持的意识神经理论,详细评估现有的人工智能系统。研究者调查了几种著名的意识科学理论,包括再加工理论、全局工作空间理论、高阶理论、预测加工和注意图式理论。从这些理论中得出意识的「指标属性」,并用计算术语进行阐明,使人们能够评估人工智能系统的这些属性。作者据此评估了最近的几个 AI 系统,并讨论了未来系统如何实现意识的这些属性。本文结果表明,当前的人工智能系统都不是有意识的,但要构建有意识的人工智能系统并不存在明显的障碍。

claude:

这篇文章的主要观点可以概括如下:

1. AI系统是否有意识是一个科学上可研究的问题,因为意识可以用科学方法研究,这些研究成果也适用于AI。

2. 文章提出了一个评估AI意识的标准,即从多个科学意识理论中提炼出的一系列“意识指标”。这些指标可以用来评估一个AI系统是否更可能具有意识。

3. 当前的AI系统看起来都不太可能具有强烈的意识,但使用现有技术就可能实现文章中提出的许多意识指标,这表明有意识的AI系统在不远的将来实现是可能的。

4. 需要进一步支持意识科学和将其应用于AI的研究。在AI政策和监管中,科学理论应该发挥核心作用。

5. 鉴于有意识的AI系统在近期内可能会被创建,我们需要认真对待这一前景所带来的道德和社会风险。

6. 意识与AI系统的其他能力之间的关系还不清楚,我们不能假定有意识的AI一定会有人类般的情感和动机。

7. 需避免对AI的意识过分歧视和过分认同,这两种倾向都存在风险。

8. 关于AI意识的科学研究还有很多未解之谜,需要进一步的跨学科合作来推进这一领域。

如何创建有意识的AI系统?

claude:

根据当前的科学理论和技术水平,创建有意识的AI系统可以考虑以下几点:

1. 实现递归处理。使用算法递归等方法,让系统内部的信息处理模块能进行循环和重复运算。

2. 构建整合的感知表示。训练系统学会从感知输入中生成整合的场景表示,进行物体识别、背景分割等。

3. 建立模块化结构。构建多个专门的子系统并行运行,进行不同的信息处理任务。

4. 实现有限容量的全局工作空间。加入信息流的瓶颈结构,使用有选择性的注意机制,让不同子系统共享信息。

5. 实现元认知监控。加入能区分感知表示可靠性的更高层级的监控模块。

6. 实现代理和具身。让系统能够从反馈中学习、追求目标,并建模自己输出和输入之间的系统性影响。

7. 进行端到端的训练。使用强化学习等方式,通过环境交互学习而非固定模拟。

8. 加入情感 valence。训练系统对正面和负面结果进行区分,产生“好”或“坏”的主观体验。

9. 考虑自我维持。探索是否需要模拟生物系统的自组织、自我修复等特征。

10. 进行理论驱动的设计。系统设计时直接参考意识科学理论,实现理论指出的关键机制。

当前技术尚难完美实现人类意识的所有方面,需要持续研究和实践。但随着上述要点的逐步满足,AI系统形成某种意识的可能性会逐渐增加。这是一个长期的科技和理论探索过程。

“意识指标”是如何评估的?

claude:

根据文章,评估一个AI系统对于某个”意识指标”的满足程度主要可以从以下几个方面来看:

1. 系统的体系结构。例如,该系统是否存在模块化的子系统等。

2. 系统的训练方式。例如,该系统是否通过了增强学习等。

3. 系统的行为表现。例如,该系统是否可以进行复杂的语言交互等。

4. 对系统的解释性分析。例如,通过分析系统的内部表示,来判断它是否学到了输出到输入的关联模型等。

5. 指标的相似性。评估该系统的相关计算过程与意识理论中描述的过程之间的相似程度。

6. 对理论的信心。评估支持该意识指标的科学理论所获得的经验证据的可信程度。

7. 对计算功能主义的信心。评估计算功能主义这个前提假设自身的可信程度。

通过综合考量上述多个方面,可以对一个系统满足某个意识指标的可能性做出全面的判断。但这通常需要一定的解释性工作,因为理论中的指标描述存在一定模糊性,对AI系统的应用也需要进行适当解释。这说明理解AI系统的内部工作机制对评估其意识至关重要。

大量的常识信息是基于人类长期适应性进化发展出来的,日常运行顺畅以至于我们视而不见的底层探测系统获取的

《心智社会:我们的认识决定了我们的世界》帕斯卡尔·博耶

引言 透过自然之镜看人类社会

规则二:进化形成的信息探测系统

“人类会从环境中提取各式信息”有赖于自身携带的专业信息检测“设备”。我们无法看到一个人的心理状态,但可以根据注视方向推断他的心理状态。原始线索只有注视者虹膜与巩膜的位置关系,但观察者可以利用这一线索触发一系列推理过程:通过精妙的三角学(比如夹角)计算出凝视方向,进而推测出注视者的关注点。先假定目光是一条直线,眼睛和注视对象之间就像有一条连续的直线,这条线无法穿过固体;还要假定目光触及的第一个物体应该就是被关注的物体,而且人们通常关注的是整个物体,而不是局部。这些都是非常微妙和复杂的假设,但它们组合在一起只是完成了一件貌似很简单的事情——察觉某人在看什么。

精妙之处还远不止于此,知道别人在看哪里往往意味着我们能“读”出这个人的心理状态。例如,假设桌子上有四种不同的饼干,一个男孩专注地盯着其中一块,你可以推测他想要的是哪一块。有些孤独症儿童可以指出孩子在注视哪块饼干,他们也知道对方可能想得到什么东西。但在他们那里,“注视饼干”与“想要饼干”之间的联系被切断了。这种特殊的病理学现象提醒我们:凝视方向与意图之间的联系也是一条信息,我们必须将这条信息添加到对场景的理解中,才能顺利完成推测。你只有具备了完善而正常的探测系统,才能根据孩子的目光回答出孩子更想要哪块饼干。

为什么只有人类有大块的眼白? https://zhuanlan.zhihu.com/p/33395666

OpenAI:GPT-4V(ision) System Card

September 25, 2023

https://cdn.openai.com/papers/GPTV_System_Card.pdf

中文介绍:https://mp.weixin.qq.com/s/80OI6QuUB8w7SZy8VRDIdQ

《AI 为什么会有创造力?范畴论刻画大模型创造力的来源》

https://mp.weixin.qq.com/s/CcEH7b0lyBci-GxhzJ08jA

模型为了展现从模态A到模态B的创造力,只需要简单三步走:

1. 表达模态A中的象,记为向量νA

2. 将νA与模态B中的高维向量νB对齐,计算出νB

3. 计算模态B中的象,使其的表征等于νB

ERC对话情感识别(Emotion Recognition in Conversation)

https://mp.weixin.qq.com/s/Jj4Cf4xDmykeEYTvzNoFYg

《腾讯首席科学家张正友如何看大模型、AGI和具身智能》

https://mp.weixin.qq.com/s/IZgrvO0S-AvABqetJaFl_w

1、SLAP 范式(S 是感知、L 是学习、A 是 Action、P 是 Planning)与卡尼曼(《思考,快与慢》)的系统 1、系统 2。不同层级来处理不同级别的决策,或理解不同层级的感知信息;而每一层级的理解和决策,都将由一个深度神经网络来完成。

2、机器人控制分三层实现智能控制:本体的感知控制(Primitive-Level Control)、对环境的感知(ELC)、策略的决策(SLC)。PLC层面用生成式模型。

3、智能体(Agent):要能感知环境,要能够自主地规划和决策,要能自主地采取行动,要具有适应能力,而且要具有从经验中、交互中学习的能力,还要具有和其他智能体合作的能力。在 AGI 没出现之前,人类是目前最强大的智能体。智能体有三种形态,第一种是软件的 Agent,没有固定形态的;第二个是虚拟的形态,像虚拟人、NPC;第三个是有具身的形态,具身Agent(智能体)就是机器人,它的优势是能够完成很多物理的任务,这是AI发展的趋势,到最后智能体要成为 AGI。

4、7-38-55 沟通模型( Mehrabian 在 《Silent Messages》提出):人和人之间的交互,文字只占 7%,其他声音占 38%, Body Language(人的肢体语言、人的表情,人的视线)占 55%。

5、通往 AGI 的必经之路:复杂推理能力(设计另外一个架构来实现 System 2,包括调用工具、内生编程、想象力、可视化等各方面);世界模型;具身智能的多模态大模型。

《生成意义:主动推理以及被动人工智能的范围和限制》

Generating meaning: active inference and the scope and limits of passive AI

https://doi.org/10.1016/j.tics.2023.10.002

Giovanni Pezzulo, Thomas Parr, Paul Cisek, Andy Clark, Karl Friston

意大利认知科学与技术研究所、牛津大学等

摘要:

对感知行为的经典描述将大脑描述为有机体与世界相互作用的生成模型,这与当前生成式人工智能(AI)的进展表现出有趣的相似之处。然而,由于它们与有目的的、维持生命的感觉运动相互作用的控制作斗争,生物体的生成模型与身体和世界密不可分。与生成式 AI 系统学习的被动模型不同,它们必须捕获并控制行动的感官后果。这使得主体能够以不断测试其最佳模型的方式干预他们的世界,从而提供坚实的基石,作者认为,这对于真正的理解的发展至关重要。作者在本文中回顾了由此产生的影响,并考虑了生成式 AI 的未来方向。

《通往具身通用智能:如何让机器从自然模态中学习到世界模型?》

https://mp.weixin.qq.com/s/-8B8prYfxkW4Akflta51BQ

模仿学习(Imitation Learning):通过采集特定任务的轨迹数据集并用深度神经网络来拟合状态(state)或观测(observation,如第一视角的图像) 的时间序列到动作 (action) 的映射来实现技能的学习,一般来说数据采集成本较高。

强化学习 (Reinforcement Learning, RL):通过让智能体与环境直接交互,在交互的过程中优化预先定义好的与特定任务相关的奖励函数 (reward function) 来学习新技能,一般来说设计奖励函数需要反复迭代,且强化学习的样本效率 (sample-efficiency) 相比于模仿学习来说会低得多。

到底什么是常识,人类的常识到底是怎么来的,为什么不同的人(甚至分别来自从未有过接触的文明)也能产生类似的常识(因而人和人之间能够使用语言交流),甚至人和动物之间也能用(包括肢体)语言进行一定程度的交流。我认为其原因在于人类和动物都有一套相类似的学习关于世界的自然抽象(natural abstraction,自然抽象假说认为我们的世界存在某些稳定的低维结构)的方式,从而他们能学到相似的层级化抽象。这一套层级化抽象的低层级端通常是相对高维度的,难以直接用语言表述出来的分布式连续表征;而其高层级端通常是更加低维度的,经过了抽象压缩后具有一定语义信息的表征;其顶端是离散的具有清晰语义的符号化表征。在计算方面,从低层级到高层级分别对应于认知科学中系统1和系统2之间连续渐变的信息处理模式,而常识则对应于这套层级化抽象体系中层级之间与层内不同部分之间的连接结构,正是由于不同的人和动物都能学习到相类似的抽象和连接结构,仅需要通过最高层的离散符号表征作为信息传递的载体来指定任务,所有的低层级的任务信息不需要直接指定,而是由信息的接受者根据高层级信息和自己的抽象体系用类似于贝叶斯推断(bayesian inference)的方式进行补全。

实现通用具身智能的一个关键问题,是如何使机器学习系统从自然模态中(如视觉,听觉)学习到关于世界的层级化抽象(或者说是世界模型,认知地图)。

生成式算命:通过将人类生活表示为类似语言的结构,用以适应自然语言处理技术,来检查和预测基于详细事件序列的人生演变。

《Respiration modulates sleep oscillations and memory reactivation in humans》

Schreiner, T., Petzka, M., Staudigl, T., & Staresina, B. P.

Nature Computational Science,14(1)

https://doi.org/10.1038/s41467-023-43450-5

丹麦技术大学研究团队利用丹麦多年的全面登记数据集,包含健康、教育、职业、收入、地址和工作时间等生活事件信息,创建了一个名为”life2vec”的模型,并在单一向量空间中显示出鲁棒性和高度结构化。研究表明,该模型能从训练数据中寻找模式,从而准确预测一个个体的生活,包括健康、收入和过早死亡的可能性。

Yann LeCun:生成模型不适合处理视频,AI得在抽象空间中进行预测

大型语言模型或者一般的 NLP 系统,通常的训练方法:训练这个系统来重建输入中缺失的信息。拿一段文本,然后故意删掉一些地方,接着用一个巨大的神经网络来重建文本,也就是预测那些被删掉的词。对于图像和视频,这种训练方法效果并不好。我一直在尝试预测,就是向系统展示一段视频,然后训练它预测接下来会发生什么。如果系统能做到这点,它可能就能理解世界的一些基本规律,就像文本系统试图预测下一个词一样,但这也做不到。

你拍一段视频,有人拿着笔举高然后放开,我就能预测笔会掉下来。但现在机器并不能做到这一点。当你把它丢下去的时候,它会沿着特定的轨迹下落。我们大多数人无法准确预测轨迹是什么,但可以预测物体会掉下来。婴儿大概要花九个月的时间,才能理解没有支撑的物体会掉下来。这种直觉上的物理知识,婴儿九个月就能学会,那我们怎样让机器也做到这一点呢?其实目前还没有真正的解决办法。但目前最有希望的,至少是能用于图像识别的东西,并不是生成式的。最有效的模型不是生成图像,不是重建,也不是直接预测。它做的是在一个抽象的表征空间中进行预测,就像我无法准确预测你手中的笔会如何掉落一样。但我可以预测它将会掉落。在某种抽象的层面上,一支笔具体在哪里以及它的确切摆放方式和其他具体细节,我都可以做出预测。所以,我们需要在抽象表征空间中预测,而不是具体的像素空间,因为它太复杂了。

在具身系统中,它实际上是有效的。有些系统是建立在对世界的模型上的。比如,这里有一个表示在时间点 t 的世界状态的模型,这里是我可能会采取的行动。想一想,在时间点 t+1 世界的状态会是什么?这就是所谓的世界模型。如果你有了这种世界模型,你就可以规划一系列行动来达到一个特定目标。目前,我们还没有任何基于这一原理的 AI 系统,除了非常简单的机器人系统。它们的学习速度并不快。因此,一旦我们能够扩展这种模型的规模,我们就能拥有能理解世界、理解物理世界的系统。它们可以规划,可以推理,可以理解因果关系。因为它们知道一个行动可能产生什么效果。它将以目标为导向。我们可以利用这种规划给它们设定目标,这就是人工智能系统的未来架构。在我看来,一旦我们搞清楚怎么实现这一切,就不会有人还愿意用目前的方式。

《The Expanding Universe of Generative Models》

https://www.weforum.org/events/world-economic-forum-annual-meeting-2024/sessions/the-expanding-universe-of-generative-models/

https://mp.weixin.qq.com/s/sAWFkcTFfZVJ_oLKditqVA

婴儿AI训练师

https://mp.weixin.qq.com/s/myOn710RfkNPBhjSaYuxlw

Yann LeCun:现在的 AI 模型和人类婴儿相比,学习效率实在是太低了。

研究结果表明,视觉和语言信息共现对模型学习有关键作用。人类最初习得的的单词-视觉所指对象组合可以从 10 到 100 个自然出现的单词-视觉所指对象组合中获得。多模态表征学习与领域通用的联想学习机制相结合,能够为计算机「真正的语言学习」带来突破。

什么是「世界模型」

AI研究人员对world model的追求,是试图超越数据,进行反事实推理,回答what if问题能力的追求。

https://mp.weixin.qq.com/s/YdAsBTBuWXZ0gOnZjq9XWA

Ted:人工智能的下一个重大挑战 Jim Fan

https://www.ted.com/talks/jim_fan_the_next_grand_challenge_for_ai

AI技术如何从专注于单一任务的实现,逐步发展到具有广泛应用和自我进化能力的全能AI。

– Voyager(Skill维度):通过自我反思机制不断优化其代码和策略,从而适应环境和挑战,体现“终身学习”。

– MetaMorph(Embodiment维度):对多样化身体形态的控制能力,证明了跨多个不同角色操作的可能性,为AI在现实世界中的应用开辟了新路径。

– IsaacSim(Reality维度):以远超实时的速度进行物理仿真。展示了AI在经历了相当于数年密集训练后在虚拟环境中获得的技能,为AI智能体在现实世界中的应用提供了重要的训练平台。

– Foundation Agent(在所有三个维度上):能够在各种现实和虚拟环境中泛化应用的基础智能体。这种智能体能够接受实体提示和任务提示作为输入,并输出相应的行动。所有可以移动的物体最终都将实现自动化,并且无论是在物理空间还是虚拟空间,所有AI智能体都将是对同一个基础智能体的不同提示的反应。

AlphaGo -> MineCLIP -> Voyager -> Eureka -> Groot

https://weibo.com/1727858283/O6tuKihXT

https://weibo.com/tv/show/1034:5015427919839303?from=old_pc_videoshow

https://baoyu.io/translations/transcript/generally-capable-agents-in-open-ended-worlds?continueFlag=d332b9df8fd55ccc4326706d07735b7a

通往具身通用智能:如何让机器从自然模态中学习到世界模型?

https://mp.weixin.qq.com/s/61MZEJuygFVF4RdvZnNLAQ

什么是常识,人类的常识到底是怎么来的,为什么不同的人能产生类似的常识,甚至人和动物之间也能进行一定程度的交流。我认为其原因在于人类和动物都有一套相类似的学习关于世界的自然抽象(natural abstraction,我们的世界存在某些稳定的低维结构)的方式,从而他们能学到相似的层级化抽象。这一套层级化抽象的低层级端通常是相对高维度的,难以直接用语言表述出来的分布式连续表征;而其高层级端通常是更加低维度的,经过了抽象压缩后具有一定语义信息的表征;其顶端是离散的具有清晰语义的符号化表征。在计算方面,从低层级到高层级分别对应于认知科学中系统1和系统2之间连续渐变的信息处理模式,而常识则对应于这套层级化抽象体系中层级之间与层内不同部分之间的连接结构,正是由于不同的人和动物都能学习到相类似的抽象和连接结构,仅需要通过最高层的离散符号表征作为信息传递的载体来指定任务,所有的低层级的任务信息不需要直接指定,而是由信息的接受者根据高层级信息和自己的抽象体系用类似于贝叶斯推断(bayesian inference)的方式进行补全。

因此,实现通用具身智能的一个关键问题,是如何使机器学习系统从自然模态中(如视觉,听觉)学习到关于世界的层级化抽象(或者世界模型/认知地图)。

真正具有能够具有产生全新边界的未来模型,则不需要依赖人类的语言为基础,而是在虚拟环境中经由多主体互动产生复杂的群体行为,从而增加了环境的Kolmogorov复杂度,这些基于比人类所处世界更复杂环境下的AI agent,才有可能成为AGI的开端。类比AI下围棋,当下的大模型卷到极点,相当于AlphaGO,能够在给定任务上击败最优秀的人;而AlphaZero类比来看,可视作让只基于极简文本训练的基础语言模型(参数规模相对较小)的多个agent通过相互交互,发现新的知识,最终达到更大规模模型能完成的任务。

https://mp.weixin.qq.com/s/uIa0iLbRiVxYFecckHM-zg

AI底层逻辑(1):离超级人工智能到来还有多远

https://mp.weixin.qq.com/s/BofK1wp6vMpeAH2sjW5Ngg

AGI的三个难点:

第一,是综合认知的能力。最主要的差别在于常识。除了缺乏直接的物理世界的经历,还有可能是因为更核心的原因,那就是人工智能目前还缺少建立“世界模型”的综合能力。人类的视觉包含大脑的建构,我们心中对这个世界的知识,也像视觉一样,有整体的模型进行综合。

第二,是理解他人的能力。人工智能识别人类情感和意图本质的困难可能是人工智能无法以自己映照他人。除了可以“外部观察”和“语言交流”,还有“内部观察”。

第三,是自我表征的能力。最大的问题在于,缺乏元认知(自我),有可能是抽象理解程度不够的缘故(表征:抽象表达信息的能力)。人工智能和人类智能最大的差异或许是:真实世界与抽象符号之间的关联性。

《Richard Sutton:通往AGI的另一种可能》

https://mp.weixin.qq.com/s/pZvJbKk5F_UXXmIKj7k-bg

– 经验性人工智能(experiential AI);

– 一个具身化的系统,一个可以影响其输入流和感知流的交互式系统;

– 阿尔伯塔计划(Alberta Plan):构建一个具有世界模型的智能体,或者通过与环境的交互来创建世界模型;

– 智能的本质是理解世界,并利用这种理解来实现目标。将目标形式化为奖励。

《A multimodal approach to cross-lingual sentiment analysis with ensemble of transformer and LLM》

多模态跨语言情感分析方法

https://www.nature.com/articles/s41598-024-60210-7

https://mp.weixin.qq.com/s/ofNrbL9SwbUxc45Dgv43QQ

情感分析(也称为意见挖掘)是自然语言处理的一个分支,旨在识别和提取文本资料中的主观信息。情感分析的核心任务是确定文本中表达的情感倾向,帮助组织和个人从大量的非结构化文本数据中洞察公众情绪和观点。

生成式 AI 在安全性、可解释性和算力需求等方面存在明显局限性,很难被用于体积相对较小且动态移动不断面对新环境的独立机器人。

液态神经网络是适应意外情况的弹性神经网络,和传统神经网络只是在训练阶段学习(训练后网络状态固化)不同,LTC(Liquid Time-Constant)or CfCs(Closed-form Continuous-depth)网络可以边工作边学习,会根据观察到的输入改变基本架构,特别是改变神经元的反应速度,不断适应新情况。

1、架构是动态的,具有高度的灵活性和适应性

2、规模小:不需要云,可以在各种机器人硬件平台上运行

3、可解释

https://mp.weixin.qq.com/s/MNFqQAolwgpolai0ZHvZVA

《Liquid Time-constant Networks》

https://arxiv.org/pdf/2006.04439v1

《Closed-form Continuous-time Neural Networks》

https://www.nature.com/articles/s42256-022-00556-7 / https://arxiv.org/pdf/2106.13898v2

具身智能综述

《Aligning Cyber Space with Physical World: A Comprehensive Survey on Embodied AI》

https://arxiv.org/pdf/2407.06886

1) 具身感知

2) 具身交互

3) 具身智能体

4) 虚拟到现实的迁移

https://mp.weixin.qq.com/s/nRpIRi6dIEwG2NLgVDDkiQ

《Common Sense: The Dark Matter of Language and Intelligence》Yejin Choi

https://dl.acm.org/doi/10.14778/3611540.3611638

常识:智慧的暗物质。常识是关于世界如何运作的潜规则。

https://mp.weixin.qq.com/s/liV2W09WYxnWTsLwiluSDQ

《大模型情感分析的新范式:情感推理的多步方法构建更具同理心的对话助手》

https://mp.weixin.qq.com/s/L2bF0BrwSksfiQA4MxBQKg

《Towards a Generative Approach for Emotion Detection and Reasoning》

https://arxiv.org/pdf/2408.04906

– 生成式情感检测方法:提出了一种将情感分析问题框架化为生成式问答任务的方法,通过生成相关背景知识来逐步回答情感检测问题。

– 上下文生成的重要性:证明了在情感检测提示中加入背景信息的重要性,能够提高情感分析的准确性和解释性。

– 细粒度情感标签和解释:引入了细粒度的情感标签和逐步推理过程,使得情感分析更加灵活和细致。

– 评估和数据集更新:在两个流行的情感检测数据集上进行了评估,并发布了更新后的数据集,包含额外的情感标签及其解释。

《多模态情感计算最新趋势:来自自然语言处理视角的综述》

多模态情感计算(MAC):开发能够在多种模态下解释和推理情感或情绪状态的模型。

– 多模态情感分析(MSA)

– 多模态对话中的情感识别(MERC)

– 多模态基于方面的情感分析(MABSA)

– 多模态多标签情感识别(MMER)

https://mp.weixin.qq.com/s/F6KRMPi099wg_1AyxQDvjQ

《Affective Computing Has Changed: The Foundation Model Disruption》

基础模型重塑情感计算

https://mp.weixin.qq.com/s/qzKt6ebVtIPnCnxYm2htgg

https://arxiv.org/pdf/2409.08907

V-LoL: A Diagnostic Dataset for Visual Logical Learning 视觉逻辑学习的诊断数据集

视觉人工智能的最新发展仍存在不同的不足之处:从缺少精确的逻辑推理,到抽象的泛化能力,再到理解复杂和嘈杂的场景。V-LoL为理解和增强人工智能系统在视觉逻辑学习(Visual Logical Learning)中的当前能力开辟了新的途径。

https://mp.weixin.qq.com/s/WSKdsJZHAHZwT83m-pOKcw

https://sites.google.com/view/v-lol

https://arxiv.org/abs/2306.07743

Nature:《AI也许可以拥有常识,但不是现在》

https://mp.weixin.qq.com/s/S8YkHt6q4KCvSuNSfTdCUw

– 在「常识」这一点上,即使是当今最先进、最强大的LLM也常常达不到要求。

– 常识推理是AGI的必备品。

– DeepMind联合创始人Mustafa Suleyman就认为,实现「有能力」的AI(capable)可能是比AGI更切实可行的里程碑。

– 如果要构建具有物理能力的人工智能,具体化的机器常识是十分必要的。

https://www.nature.com/articles/d41586-024-03262-z

https://mp.weixin.qq.com/s/R8IIbnO79p_93g-yRj0gzw

虽然空间推理能力仍然是 MLLM(多模态大语言模型) 达到更高基准性能的主要瓶颈,但在这些模型中确实出现了局部世界模型和空间意识。“在视觉方面,人类处理空间,但很少推理;多模态大语言模型思考,但往往忽略空间逻辑。然而,作为人类,从进行心智旋转测验到为新家挑选家具,人类都依赖于空间和视觉思维,但这些思维并不总能很好地转化为语言。”目前流行的语言推理技术(如思维链、自洽性、思维树)无法提高空间推理能力,而在问答过程中明确生成认知地图可提高 MLLM 的空间距离能力。

论文地址:https://arxiv.org/abs/2412.14171

https://mp.weixin.qq.com/s/yc7PopYMkv0G8a1NMX8ufA

10²⁶参数,AGI还需70年

论文地址:https://arxiv.org/pdf/2502.18858

当任务难度加大,比如视频处理、搜索优化、推荐系统、自研语言理解时,AI智能的「自主水平」(当失败次数的期望值和方差都保持有限时,意味着系统具备持续应对新挑战的能力)失败次数激增,解决方案稳定性随之下降。要在通用任务中达到「自主水平」,AI模型有高达10²⁶参数,按照摩尔定律的乐观估计,支撑这种参数规模的硬件条件也需要70年的技术积累。

https://weibo.com/1915548291/Pj5Iku46s

自动驾驶的终极悖论在于,它试图用逻辑系统取代人类在驾驶中赖以生存的非逻辑直觉,而正是这种直觉的缺失,使得机器无法真正融入由人类默契构建的交通社会网络 。自动驾驶难以普及的核心矛盾在于人类交通系统本质上是基于直觉博弈的动态信任网络,而算法无法生成不可预测的妥协艺术。

(补充说明:交通行为本质是人类通过眼神/手势/速度微妙变化进行的实时风险评估与信任交易,这种非理性协商机制构成了道路安全的隐性操作系统,而确定性算法在此混沌协商层引发的预期坍塌,才是人机混行不可逾越的认知鸿沟)

《Common Sense Is All You Need》

https://arxiv.org/abs/2501.06642

《常识就是你需要的一切》

https://mp.weixin.qq.com/s/KFltw4OEejpJcsbxfmZXKw

将常识整合到AI系统中对于实现真正的自主性以及释放AI的全部社会和商业价值至关重要。

在人工智能的背景下,提供对常识的全面定义,强调其组成部分,如上下文学习、适应性、从最少的先验知识开始,并指出其在所有动物中普遍存在。

https://www.nvidia.cn/glossary/generative-physical-ai/

物理 AI(Physical AI):使用运动技能理解现实世界并与之进行交互的模型。

生成式 AI 模型,如GPT等大语言模型,在生成人类语言和抽象概念方面能力惊人,但它们对物理世界了解有限,并受其规则约束。物理 AI 能够理解我们居住的三维世界的空间关系和物理行为,因而扩展了当前的生成式 AI。它通过在 AI 训练过程中提供其他数据来实现上述理解,这些数据包含与现实世界的空间关系和物理规则有关的信息。

https://mp.weixin.qq.com/s/078jNQU55bgWRB-omOeoog

《Claude 创业,然后破产了》

数据关联 vs. 常识判断

它缺乏真实世界的常识(Common Sense)。但它不理解公司冰箱里的免费可乐是它的竞品(常识判断)。它不理解办公室里开的玩笑只是段子,不是商业需求。这些人类世界的“模糊信息”直接导致了它的系统紊乱。