Stephen Wolfram(2023/2/14) :

《What Is ChatGPT Doing … and Why Does It Work?》

中文:《ChatGPT的工作原理》 / 《ChatGPT是在做什么……为什么它有效?What Is ChatGPT Doing … and Why Does It Work?》

详细解构了神经网络以及ChatGPT的底层机制,以及进一步探讨了ChatGPT能几乎完美的和人类对话这个事实所触及的本质:人类语言(及其背后的思维模式)在结构上恐怕比我们想象的更简单、更具有“法则性”。而ChatGPT恰巧隐式的发现了这个法则。ChatGPT只是从其积累的“常识统计”中提取出一些“连贯的文本线索”。ChatGPT的底层人工神经网络结构最终是基于对大脑的理想化建模的,能够成功地“捕捉到”人类语言及其背后的思维的本质。语言的丰富性和它所能谈论的事物可以被封装在这样一个有限的系统中。很可能当我们人类生成语言时,许多方面的情况都非常相似。ChatGPT证明了一个基本的科学事实,即大量简单的计算元素可以做出卓越而出乎意料的事情。

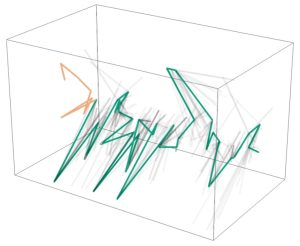

词空间向量的轨迹

词空间向量的轨迹

用GPT-4解释了GPT-2三十万个神经元 《Language models can explain neurons in language models》

LLM主要的超参数有:词表大小(Vocab_Size)、最大位置编码大小(Max_Position_embeddings)、隐层节点数大小(Hidden_Size)、隐层数(Num_Hidden_Layer)、注意力头数(Num_Attention_Heads)。

《ChatGPT 的训练过程解析》

模型+训练(PreTrain):“人工标注数据+强化学习”(RLHF,Reinforcement Learning from Human Feedback )。四个人工专家调优/训练的主要阶段:Pretraining 预训练、Supervised Finetuning 有监督微调、Reward Modeling奖励建模、Reinforcement Learning强化学习

OpenAI 2023/05/31:《Let’s Verify Step by Step》

“过程监督”:通过奖励每一个正确的推理步骤来训练模型(不仅仅是奖励正确的最终结果——“结果监督”),提升了数学问题解决能力和性能,同时在对齐(Alignment)方面也有很大价值:训练模型产生一个能被人类认可的思考链条(CoT),还能够改进“幻觉”问题。

blog: https://openai.com/research/improving-mathematical-reasoning-with-process-supervision?continueFlag=40c2724537472cbb3553ce1582e0db80

论文:https://cdn.openai.com/improving-mathematical-reasoning-with-process-supervision/Lets_Verify_Step_by_Step.pdf?continueFlag=40c2724537472cbb3553ce1582e0db80

《Explainability for Large Language Models: A Survey》

https://arxiv.org/abs/2309.01029

https://mp.weixin.qq.com/s/d07JiymZI3eSpQJ6AxIfEw

注意力头的 “物理学”:《捕获AI的注意力:重复、幻觉、偏见背后的物理学》

https://mp.weixin.qq.com/s/ZSRmw_m4XwJEeHl2AyHcdA

“注意力”机制(Attention)、上下文向量、幻觉偏见背后的数学、物理学

《黄仁勋:英伟达之芯》第15章AI工厂:造芯片原本是为了打怪兽,我们却用它来造大脑

“自注意力”通过概率将树中的每个词不仅与句子中的其他词相联系,还与整个文本中的数千个其他词相联系。哪怕是出现在多个段落之前的词汇,也可能为下一个词的意义提供重要的上下文线索。

以往的神经网络架构总是试图构建完整的句子乃至段落,而Transformer则采用基于概率关系的方式,逐个预测词语,每次仅预测一个词,这便是其预测的极限。艾丹·戈麦斯(Aidan Gomez):“通过学习如何按顺序生成词语序列,模型被迫学会了极其复杂的行为模式,其中涌现出了一些令人惊叹的成果。”

利昂·琼斯(Llion Jones)观察到,如果Transformer始终只选择最合适的词语,那么生成的文章可能会显得过于呆板。因此,他灵感一闪,仿照作家使用词典的方式,为模型引入了“束搜索”功能,使其能够从多个候选词语中灵活选择。“如果你能在最顶层的词汇中找到一条策略性的路径,接着是第二层,然后是第三层,再回到最顶层,你通常会得到比一直选择最顶层词汇更好的结果,”他这样告诉我,“要实现这一点非常困难,但一旦成功,那就是我们首次获得最先近成果的时候。”