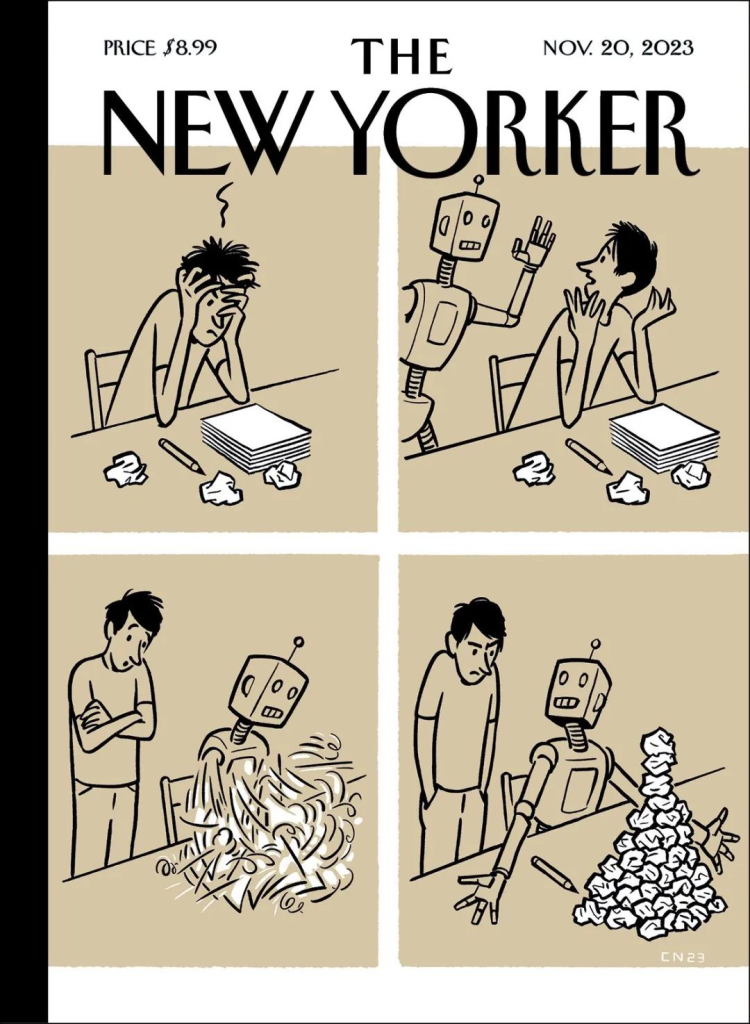

最近一期《纽约客》的封面:

如果输入的是垃圾(还有一些原材料),AIGC输出的会是整齐有序的垃圾(一点点的创意很可能还是来自它的幻觉)。

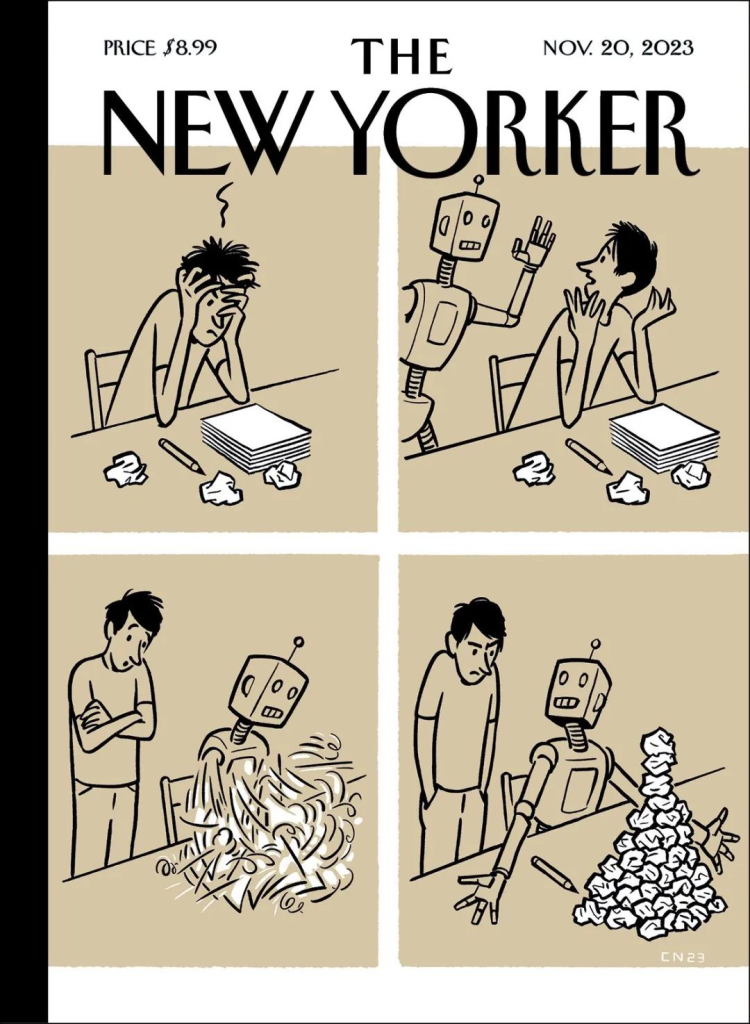

最近一期《纽约客》的封面:

如果输入的是垃圾(还有一些原材料),AIGC输出的会是整齐有序的垃圾(一点点的创意很可能还是来自它的幻觉)。

约翰·布罗克曼

04 人工智能第三定律 乔治·戴森

第一定律 阿什比(W. Ross Ashby)定律:任何有效的控制系统必须与它控制的系统一样复杂。

第二定律 冯·诺伊曼定律:一个复杂系统的定义特征一定包含对其行为的最简单的描述。生物体最简单的完整模型是生物体本身。试图减少系统行为,达到任何形式化描述的程度,只会使得事情变得更复杂,而不是变得更简单。

第三定律:任何一个简单到可以理解的系统都不会复杂到可以智能化行事,而任何一个复杂到足以智能化行事的系统都会太过于复杂而无法理解。Any system simple enough to be understandable will not be complicated enough to behave intelligently, while any system complicated enough to behave intelligently will be too complicated to understand. (佛曰:第一义皆因言说,言说是世俗,是故若不依世俗,第一义则不可说。禅宗:教外别传,不立文字。直指人心,见性成佛。维特根斯坦:凡于不可言说之物,我们都应保持沉默。)

我们完全有可能在不理解时构建某个东西。无论程序员及其伦理顾问如何监控计算程序,他们都永远无法解决这个漏洞。“好的”人工智能是个神话。我们与真正的人工智能之间的关系将永远是一个信仰问题,而不是证据问题。对那些相信他们能制造机器来控制一切的人,大自然对此的反应将是允许他们建造一台机器,来控制他们。

05 我们将如何应对?丹尼尔·丹尼特

我们不需要有意识的人工主体。我们需要的是智能工具。不让人工主体有意识的原因之一是,不管它们变得多么有自主性(原则上,它们可以像任何人一样有自主性、能自我提高或自我创造),如果没有特殊规定的话,它们不会像我们这些有自然意识的人类一样,有弱点,会死亡。我们创造的不应该是有意识的类人主体,而应是一种全新的实体,更像是圣人,没有良知,没有对死亡的恐惧,没有令其分心的爱和恨,没有个性,但是各种各样的弱点和怪癖毫无疑问会被看成是系统的“个性”:一箱箱的真理(如果我们幸运的话)几乎可以肯定会被零星的谎言所污染。学习与它们共存却不被这些人工智能奴役我们的奇点论所分心,真的很难。人有人的用处将很快改变,再次、永远地改变,但如果我们对自己的行为负责,我们就可以在危险之间掌握主动权。

07 智能的统一 弗兰克·维尔切克

1)激励驱动行动:大卫·休谟在1738年写下了“理性是,并且只应该是,激情的奴隶”这一番引人注目的言论。当然,这番话是指人类的理性和人类的激情。但休谟的逻辑、哲学观点也对人工智能有效。简单地说:驱动行为的是激励,而不是抽象的逻辑。

2)涌现:菲利普·安德森(Philip Anderson)《多就是不同》(More Is Different):“还原论假设,也就是基于简单部分的已知相互作用的物理解释具有完备性这一假设,可能仍然是哲学家们争论的话题,但对于大多数活跃的科学家,我认为他们会毫无疑问地接受这一假设。对于大而复杂的基本粒子聚集体的行为,不能用几个粒子表现出来的性质进行简单外推。”大小和复杂性每升到一个新级别,都会有新的组织形式出现,其模式以新方式编码信息,其行为以新概念进行描述。

从两个得到有力支持的假设中,我们得出一个简单的结论:

◎ 人类的心智源于物质。弗朗西斯·克里克《惊人的假说》(Astonishing Hypothesis):“心智只不过是一个巨大的神经细胞组群及其相关分子之间的交互作用”。

◎ 物质是物理学定义的。

◎ 因此,人类的心智是从我们能够理解并可以人工再现的物理过程中涌现出来的。

◎ 因此,自然智能是人工智能的一个特殊情况。

3)人工智能胜过自然智能的优势是永久的,而自然智能胜过人工智能的优势,虽然目前是实质性的,但似乎这只是暂时。The advantages of artificial over natural intelligence appear permanent,while the advantages of natural over artificial intelligence, though substantial at present, appear transient.

我们可以展望在接下来的几代人里,人类通过智能设备变得更强,将与越来越有能力的自主人工智能共存。那时将有一个复杂的、迅速变化的智能生态系统,并因此迅速进化。考虑到工程化设备最终将具有的内在优势,进化的先锋将是机器人和超级头脑,而不是微不足道的智人。我们的不受太阳系、银河系限制的未来,如果没有人工智能的帮助,将永远无法实现。

奥拉夫·斯塔普雷顿(Olaf Stapledon)1935年《怪约翰》(Odd John)小说中的英雄,一个突变超人,将我们智人形容为“精神的始祖鸟”。“始祖鸟是一种高贵的动物,它能进化成更高级的生物。”他充满深情地把这句话说给他的一个普通人类的朋友和传记作家听。

《存在主义心理学的邀请》博·雅各布森

第7章 混乱与意义 生活的目标、意义和价值

2.1.2.3.1 戈登·奥尔波特人格分类理论

奥尔波特把人分为6种类型,每种类型都有其独特的特征和动机驱动力。有些人似乎就是奥尔波特所确定的某个类型,但许多人还代表了多种类型的混合。

1、理论型:活着为了发现和揭示真理。生活中最重要的事情就是寻求知识和理解,或者以某种方式向别人展示通往真理的道路。

2、经济型:以事物的效用为导向,重要的是事物的用途及其经济价值。为了创造利润,最重要的是看到自己业务或存款的增长。

3、审美型:以事物的和谐为导向,美才是最重要的。生活被视为对各种事物的感受和享受。

4、社会型:把友爱和亲近他人作为最重要的生活价值。这类人想要对别人有用并帮助他们。

5、权力型:对权力感兴趣,重要的是能够将自己置于高位,并对他人施加影响。

6、宗教型/传统型:寻求与超越日常世界的事物合一。这种追求的形式可能是坚持某种特定的宗教习俗,也可能是寻求某种不太明确的精神形式。

马斯洛需求层次理论中的高层次需求(如尊重和自我实现)可能与戈登·奥尔波特六种类型理论中的某些类型相关。满足高层次需求可能需要人们发挥自己的个性特征和才能。同时,人们在追求马斯洛需求层次理论中的各种需求时,可能会表现出戈登·奥尔波特六种类型理论中所描述的不同风格和偏好。

2.1.2.3.2 生活目标和价值属于特定的生活阶段?

一些心理学家(布勒、荣格、克尔凯郭尔、弗兰克尔)建立了关于生活目标和价值变化的理论,如弗兰克尔:

1、创造性价值(creative values)是在建设和给予等一系列活动中实现的,是人们在家庭生活和工作领域中追求的。这种价值具有扩张性,倾向于建立和扩大个体的世界。

2、体验性价值(experiential values)实现于个体向世界敞开自己的能力,以及融入自然、欣赏艺术和爱的能力。实现这样的价值,就要过一种体验丰富的生活。这种价值具有接纳性,让个体拥抱整个世界。

3、态度性价值(attitudinal values)体现于个体能够让自己面对受限的环境、痛苦的现实,以及在残酷命运面前的屈服。这种价值在个体面对疾病或死亡时会发挥作用。当我们不得不放弃一些未能实现的目标时,我们也会召唤这种价值。因此,接受我们的命运并在其中寻找意义,本身就成了一项任务。根据弗兰克尔的说法,人的生命直到最后一秒都保留着它的意义。当然,只要有可能,我们会优先实现更积极的价值。与痛苦相关的态度性价值,只有在迫不得已的情况下才会考虑:“因此,一个人承受命运有两方面的含义——在可能的地方创造,在必要的地方忍受”。

通常的模式是,人们在年轻时尝试实现创造性、扩张性的价值,努力通过工作和建立家庭来塑造自己的存在。在后来的生活中,人们更倾向于实现体验性价值,比如享受自然、艺术以及爱的感觉。到了生命的最后阶段,当命运变得不那么友善时,人们面临的任务便是实现态度性价值,在苦难中寻找意义。

2.1.2.3.3 重大事件/环境改变生活的目标和意义?

外部环境的突然冲击可能会以两种方式影响一个人:一方面,一个人的生活方式和活动模式可能会因此停滞不前,仿佛被冻结在时间中;另一方面,个人的发展也可能会发生强化。

2.1.2.3.4 各个阶段是事先安排好的?

如果生命周期在走向人生的结尾时,会通往一个更高级的阶段,那么有意识地努力更早达到这个更高级的阶段,是否是个好主意呢?应该摆脱自己当前的层次,努力达到一个更高的阶段吗?还是应该在较低的层次上充分生活,然后自然地过渡到下一个阶段?荣格的回答可能是,生活应该在人们恰好发现自己的那个层次上进行。每个阶段都必须根据其内在性质而充分地经历。相反的观点可能会建议一种平衡的生活方式,在一生中寻求将工作和家庭生活、智力和艺术兴趣、外向和内向活动结合起来。

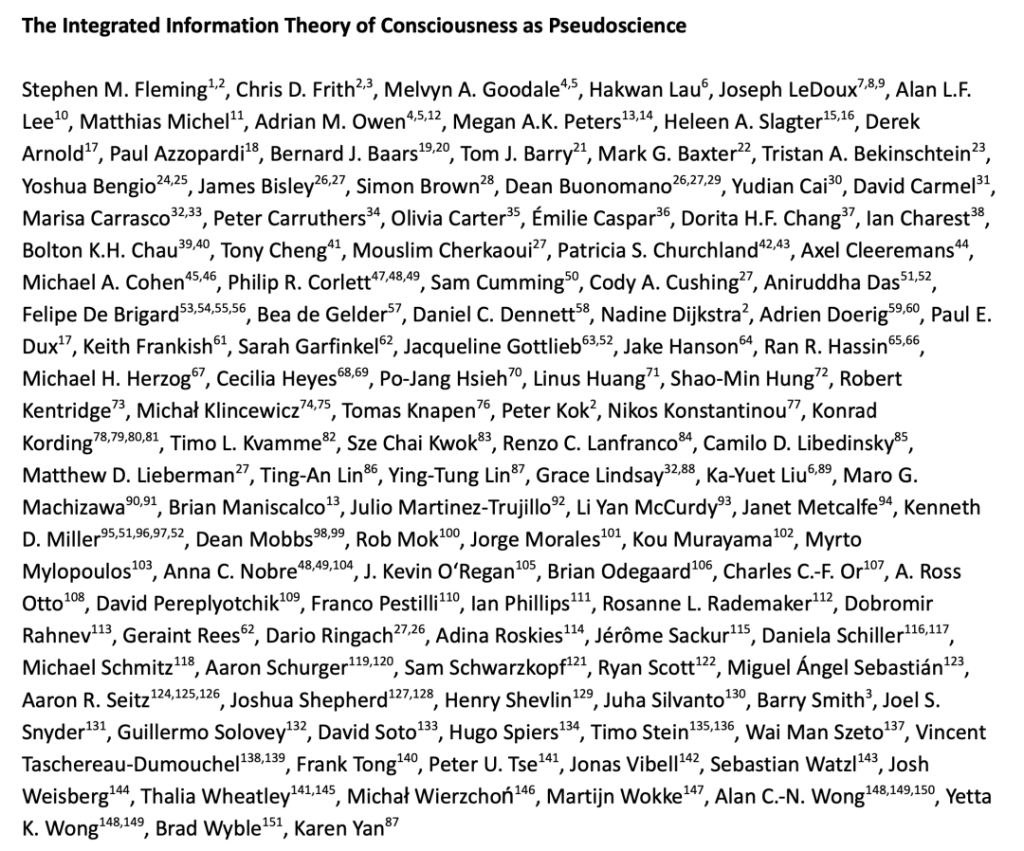

《124位科学家批评整合信息论是伪科学:我们该如何探讨意识难题?》https://mp.weixin.qq.com/s/_mqKrEYPd4lR7EmABBqspQ

《The Integrated Information Theory of Consciousness as Pseudoscience》https://psyarxiv.com/zsr78

《心智社会:我们的认识决定了我们的世界》帕斯卡尔·博耶

1、大量决策的基础是经过长期进化形成的c0意识:

2、需求层次(2.1.2 人的需求层次)下层的需求会更多的直接关联c0意识。只有长期符合c0意识的需求,才能够有持续性,即重大决策需要“跟随心的方向”。

3、c0意识可以通过c1、c2意识逐步的调整、转变、固化,如从先天进化形成的嗜糖逐步到厌糖。

2.2.2.2.1 《AI新生》

《AI新生:破解人机共存密码:人类最后一个大问题》 斯图尔特·罗素

一切科学发现都依赖于一层又一层的概念,这些概念可以追溯至历史和人类经验。在科学哲学中,新概念的发现经常归因于三个妙不可言的“I”:直觉(intuition)、洞察力(insight)和灵感(inspiration)。

2.2.2.2.1.1 AGI:以可持续的方式将地球上每个人的生活水平提高到发达国家认为相当体面的水平

通用人工智能是“一切即服务”(Everything-as-a-Service,EaaS)。我们没有必要为了执行一个项目而雇用不同学科的专家队伍,把他们按照承包商和分包商的等级组织起来。通用人工智能的所有化身将会获得人类的所有知识和技能,而且还不只是这样。它们唯一的区别在于实体能力:用于造建筑或做手术的四肢灵巧的机器人,用于大规模货物运输的轮式机器人,用于空中检查的四轴飞行器机器人等。使这一切成为可能的正是通用智能的通用性。

不需要基于进一步的革命性技术,只是基于人工智能系统更有效、更大规模地利用我们现有资源的能力,就可以实现全球人均GDP增长10倍。从1820年到2010年,全球人均GDP增长近10倍花了190年,这需要工厂、机床、自动化、铁路、钢铁、汽车、飞机、电力、石油和天然气生产、电话、广播、电视、计算机、互联网、卫星和许多其他革命性发明的发展。人工智能的成功将催生“一条文明轨迹,实现富有同情心地使用人类被赋予的宇宙资源的文明的进步”。

2.2.2.2.1.2 超级智能的局限

一个常见的错误是人们倾向于认为超级人工智能系统拥有无所不知的神圣力量。

机器还受到现实世界对新知识获取速度的限制。虽然在经验科学中,由机器瞬间产生科学发现是不可能的,但我们可以期待,在机器的帮助下,科学的发展速度将会更快。

它们在试图模拟和预测人类这种特定的对象时存在固有的劣势。

人工智能可以提供的功能是受限的。土地和原材料并不是无限的,骄傲(荣誉感)也是受限的:在给定的所有指标中,只有1%的人可以排在前1%。因此,对我们的文化而言,逐渐淡化骄傲和嫉妒是感知自我价值的重要因素。

我们对心智科学的理解非常有限,我们对幸福和满足的科学理解甚至更有限。我们根本不知道如何以一致的、可预见的方式为彼此的生活增加价值。

2.2.2.2.1.3 目标/目的

05 过于智能的人工智能

1960年,诺伯特·维纳发现了一个核心问题:正确且完整地定义真正的人类目的是不可能的。这反过来又意味着我所说的标准模型——人类试图将自己的目的灌输给机器,注定要失败。价值对齐的失败:我们可能会向机器灌输与我们的目标不完全对齐的目标,这或许是在不经意间完成的。维纳:“过去,对人类目的的片面和不充分的看法相对无害,只是因为当时受到技术上的限制……这只是人类无力保护我们免受人类愚蠢行为的破坏性影响的众多例子之一。”“我们可以谦逊地在机器的帮助下过上好日子,也可以傲慢地死去。”

输入这种机器的“目的”并不是用各种各样的方式接管世界,而更有可能是利润最大化或参与度最大化,抑或是一个其他看似良性的目标,比如在定期的用户幸福度调查中获得更高的分数,或者减少我们的能源使用。现在,如果我们认为自己是“通过行动有望实现我们的目标的实体”,那么有两种方法可以改变我们的行为。第一种是老派的方法:保持我们的期望和目标不变,但要改变我们的环境,例如,通过给我们钱财,用枪指着我们,或者让我们忍饥挨饿而屈服。对计算机而言,这往往既昂贵又困难。第二种方法是改变我们的期望和目标,这对机器来说要容易得多。机器每天与你保持数小时的联系,控制你对信息的访问,并通过游戏、电视、电影和社交互动为你提供大量的娱乐。

能够产生全球影响的超级智能系统并没有模拟器,也没有重来的机会。仅靠人类去预测和排除机器为实现特定目标而选择的所有灾难性方法当然是非常困难的,甚至是不可能的。一般而言,如果你有一个目标,而超级智能机器有一个不同的、与你冲突的目标,那么此时机器会实现它的目标,你却无法实现自己的目标。

06 不那么伟大的人工智能辩论

– 情况很复杂、现在担心还为时过早、你无法控制研究

– 难道我们不能……关闭电源、把它放进盒子里、在人机团队中工作/与机器融合

– 难道我们不能……避免输入人类目标

“避免输入目标”思想的一种常见变体是这样一个概念:一个足够智能的系统必然会由于其智能而自行制定“正确”的目标。

尼克·波斯特洛姆“正交性理论”:智能和最终目标是正交的:原则上,几乎任何水平的智能都能与几乎任何最终目标相结合。即智能程度是定义智能系统的一个轴,而目标是另一个轴,我们可以独立地改变它们。一个通用智能系统可以或多或少地被赋予任意目标,包括最大化回形针的数量或已知圆周率的位数。算法是完全通用的,可以接受任意奖励信号。智能系统可以通过观察世界来获得应该追求的目标,这一想法表明,一个足够智能的系统会自然而然地放弃其最初的目标,转而追求“正确”的目标。

罗德尼·布鲁克斯(Rodney Brooks)断言,一个程序不可能“足够聪明,使它能够发明方法来颠覆人类社会,以此实现人类为其设定的目标,却不了解它这么做会给为其设定目标的同一群人带来问题”。“实现人类设定的目标”的最佳计划正在给人类带来问题。

史蒂芬·平克:“智能是运用创新手段实现目标的能力。目标与智能本身无关。”[“让机器去选择最能满足相互冲突的目标的动作,这种能力不是工程师可能忘记安装和测试的附加功能,这种能力就是智能。在语境中理解语言使用者意图的能力也是智能。”“满足相互冲突的目标”并不是问题所在,这是从决策理论早期就已被内置到标准模型的东西。

我们人类一来关心其他人的偏好,二来知道我们不知道所有人的偏好是什么。

我们面临的难题:如果我们构建机器来优化目标,那么我们输入机器的目标必须符合我们想要的目标,但我们不知道如何完全正确地定义人类目标。

2.2.2.2.1.4 有益的人工智能系统三原则

07 人工智能:一种不同的方法

我们的任务:设计高度智能的机器,让它们帮助我们解决难题,同时确保这些机器的行为永远不会让我们感到非常恼火。这个任务并不是给定你一台高度智能的机器,让你找出控制它的方法。一台被视为黑盒子的、已成现实的机器,没准儿是从外太空来的。我们能控制一个从外太空来的超级智能实体的概率几乎为零。

有益的人工智能系统三原则:

1.机器的唯一目标是最大限度地实现人类的偏好。

2.机器最初不确定这些偏好是什么。

3.关于人类偏好的最终信息来源是人类行为。

10 问题解决了吗?

人工智能有重塑世界的能力,而对重塑的过程,我们必须以某种方式加以管理和引导。

依赖于对外部提供的固定目标进行优化的机器,这种模式存在根本性的缺陷。只有在目标确保完整且正确,或者可以很容易地重置机器的情况下,这种模式才有效。随着人工智能变得越来越强大,这两个条件都将不成立。

有益的机器:其行为预期可以实现我们的目标的机器。因为这些目标在我们心中,而不在它们内部,所以机器需要通过观察我们做出的选择和如何做出选择来更多地了解我们真正想要的是什么。以这种方式设计的机器会顺从人类:它们会征求许可;当指令不明确时,它们会谨慎行事;而且它们会允许自己被关掉。

我们越来越有可能把我们的知识放到机器里,让机器自己来运行我们的文明。把我们的文明传给下一代的实际动机一旦消失,这个过程就很难逆转了,正如电影《机器人总动员》所设想的那样。对任何一个人而言,通过多年艰苦的学习来获得机器已经拥有的知识和技能似乎毫无意义,但如果每个人都这样想,那么人类将会集体失去自主性。这个问题的解决方案似乎是文化上的,而不是技术上的。我们需要一场文化运动来重塑我们的理想以及对自主、能动性和能力的偏好,远离自我放纵和依赖。

人工智能领域有个“莫拉维克悖论”(Moravec’s Paradox):难的问题简单,简单的问题难。汉斯·莫拉维克:“与一般的观点相反,要让电脑如成人般地下棋相对容易,但是要让电脑有如一岁小孩般的感知和行动能力却是相当困难甚至是不可能的。”尽管人工智能可以在围棋上战胜最优秀的人类选手、精确地诊断癌症、流利地写文章/程序代码,数据分析师、翻译、经纪人、作家/画家/作曲家、程序员都要小心他们的位置被取代,但是园丁、接待员和厨师近几年不用担心他们的岗位。

假设在莫拉维克预言的智能机器取代人类的2040年,一家酒店雇用了一个加持了GPT-13(具身智能新成果机器人接入大模型),有全面的多模态感官能力(听说、视觉、触觉等)及机械灵巧性,懂200种语言、武力值为99的机器人保安,让我们看看这个机器人可能遇见的情况:一只小狗尖叫着跑进大堂,喝醉的流浪汉骚扰前台,一位顾客突然中暑,蒙面劫匪持枪闯入,旁边是戴面具拿水枪的孩子……它该如何适当的处理这些不同的对象,以确保酒店的安全和客户的满意度?

2.2.1.5.1 AIGCs(AI Generated Commonsense)

AI必须要能够学习、使用背景知识/常识(Commonsense),才能够在这样的复杂环境中知道如何随机应变。下一个AIGC(Artificial Intelligence Generated Content)是AIGCs:AI生成常识。

《测算与判断:人工智能的终极未来》第三章 失败:老派人工智能的根本局限性

现实本身异常丰富。围绕所谓的现实,任何本体论的解析只提供部分信息。通过抽象化或理想化的表征、描述、模型等方式解释、图示和过滤世界,概念性的“画面”会对某些方面进行强调或特别指出,而对其他方面则是暗示或弱化(甚至是扭曲),并忽略或抽离现实世界潜在的无限丰富性。人工智能面临的问题是,为了在现实世界中发挥作用,它需要能够处理实际意义上的现实,而不是我们所认为的现实,准确地讲,不是我们的思想或语言所表征的现实。

人工智能需要解释对象、属性和关系,并以此来解释各种造物发现世界可理解的能力,而不能预设对象、属性和关系。开发适当的注记能力不仅能够“吸收我们感官所感知到的东西”(这远远不够),而且能够发展出一个对存在于这个世界而言负责任且可靠的完整的集成图景。第一代人工智能的本体论假定、对注记的细微差别视而不见,以及对世界丰富程度的认识不足,是常识方面的表现令人失望的主要原因。

2.2.1.5.2 如何学习常识

常知类似于语言,是不能被理性主义的形式化理论所模拟的。人们在使用语言时,既不是通过严格的规则实现语言的运用,也不是通过严格的规则来学习语言(当然也就谈不上对学习语言的智能活动过程形式化了)。人类对语言的使用往往在语言的灵活应用中找到了语言的美感。AI如何能够学习、使用常识,需要参考ChatGPT如何能够学习、使用语言的(应该不是专家系统、知识图谱的逻辑主义技术路线)。

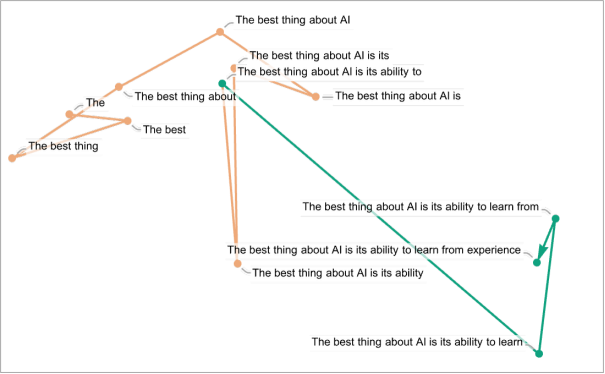

通过语言模型及其训练过程,ChatGPT“发现”了语法规则这些“语言规律”并很擅长遵循它们。同时能够实现“语义运动定律”——输出有意义的文本,定义或至少约束着语言特征空间中的点在保持“有意义性”的同时如何移动。通过查看大型文本语料库可以得到每个单词的常见程度的估计,ChatGPT 根据概率来选择生成下一个词。ChatGPT只是从其积累的“常识统计”中提取出一些“连贯的文本线索”。在ChatGPT内部,任何一段文本实际上都由一组数字表示,可以看作是某种“语言特征空间”中的一系列点的坐标。当ChatGPT继续一段文本时,相当于在语言特征空间中描绘出一条轨迹。

ChatGPT的底层人工神经网络结构最终是基于对大脑的理想化建模的,能够成功地“捕捉到”人类语言及其背后的思维的本质。语言的丰富性和它所能谈论的事物可以被封装在这样一个有限的系统中。很可能当我们学习和使用常识时,会采用非常相似的方法,例如构成Commonsense的向量空间,从其积累的大量“三维活动统计”中提取出一些“连贯的常识线索”。通过LCM(Large Commonsense Model,大型常识模型)及其训练过程,发现常识的规则及内部蕴含的意义。

2.2.1.5.3 什么时间可以实现

对机器人来说,简单的动作都需要极为复杂的机械控制系统来实现。而现实生活中常见的简单任务,把流程分解成每一个动作,并且要做到“不走形”,“容易”问题层层累加,难度是指数级递增的,是类似于从井字棋到围棋的搜索空间能力要求的提升,需要在图像嵌入设计方法、搜索方法(策略矩阵、价值矩阵)、学习方法(工程技术)、数据来源等方面的根本性的进步。

算力的发展、互联网数据的累积带来这一次(AlphaGo、GPT)的AI浪潮,我们可以在不考虑其他的技术、模型发展/要求,只从算力要求这个基本方面估算一下AIGCs出现的时间。

几个一般性假设:

0.1、假设通过物联网能够积累起丰富的、有质量的常识数据(主要是视频及人体生物信息);

0.2、假设图像/音频/视频嵌入向量空间与文本嵌入向量空间采用相似的算法及模型(视觉大模型的两条出路,向量数据库),且AIGCs的搜索算法没有质的发展/变化(统一智能体的基础模型 Towards A Unified Agent with Foundation Models);

0.3、假设机器的灵巧性、机械适应性等方面得到大幅度的发展能够支撑AIGCs;

0.4、假设摩尔定律(每1.5到2年的时间计算能力增长一倍)在未来几十年内仍然有效。

关于算力的假设:

1.1、英语大约有5 万个左右的常用词,假设现实中不同品类对象的种类及其属性的数量对计算复杂度提升一个数量级;

1.2、常识是一个在三维空间发生、发展的,有一定时间范围的过程。图像数据的维度和复杂度都比文本数据高,图像嵌入的计算量要远远大于词嵌入的计算量。假设三维空间的精细运动加上时间过程维度,对计算复杂度提升两个数量级;

1.3、其他未知因素(如对大模型幻觉的控制等)对计算复杂度提升一个数量级;

综上,计算复杂度的提升为:10^4 ≈ 2^14。

AIGCs会在未来14×(1.5~2) ≈ 20~30年左右出现。

2.2.2.1 定义

Artificial General Intelligence:AI systems that are generally smarter than humans。OpenAI:“Planning for AGI and beyond”

“Sparks of Artificial General Intelligence: Early experiments with GPT-4”

There is a rich and ongoing literature that attempts to propose more formal and comprehensive definitions of intelligence, artificial intelligence, and artificial general intelligence, but none of them is without problems or controversies. For instance, Legg and Hutter propose a goal-oriented definition of artificial general intelligence: Intelligence measures an agent’s ability to achieve goals in a wide range of environments. However, this definition does not necessarily capture the full spectrum of intelligence, as it excludes passive or reactive systems that can perform complex tasks or answer questions without any intrinsic motivation or goal. One could imagine as an artificial general intelligence, a brilliant oracle, for example, that has no agency or preferences, but can provide accurate and useful information on any topic or domain. Moreover, the definition around achieving goals in a wide range of environments also implies a certain degree of universality or optimality, which may not be realistic (certainly human intelligence is in no way universal or optimal). Another candidate definition of artificial general intelligence from Legg and Hutter is: a system that can do anything a human can do. However, this definition is also problematic, as it assumes that there is a single standard or measure of human intelligence or ability, which is clearly not the case. Humans have different skills, talents, preferences, and limitations, and there is no human that can do everything that any other human can do. Furthermore, this definition also implies a certain anthropocentric bias, which may not be appropriate or relevant for artificial systems.

有大量且正在进行的文献试图提出更正式和全面的智能、人工智能和通用人工智能的定义,但没有一个是没有问题或没有争议的。例如,Legg 和 Hutter 等人提出了一个面向目标的通用人工智能定义:智能代表了一个智能体在广泛环境中实现目标的能力。然而,这一定义并不一定涵盖智力的全部范围,因为它排除了那些可以在没有任何内在动机或目标的情况下执行复杂任务或回答问题的被动或反应性系统。人们可以想象一个人工智能,可以就任何主题或领域提供准确和有用的信息。此外,关于在广泛的环境中实现目标的定义也意味着一定程度的普遍性或最优性,这可能是不现实的(当然,人类智力绝不是普遍或最优的)。Legg 和 Hutter 等人对通用人工智能的另一个候选定义是:一个可以做人类能做的任何事情的系统。然而,这个定义也是有问题的,因为它假设有一个单一的标准能够衡量人类的智力或能力,这显然不是事实。每个人都有不同的技能、天赋、偏好和限制,没有人能做其他人能做的所有事情。此外,这一定义还暗示了某种以人类为中心的偏见,这可能与人工系统不合适或不相关。

《AI新生:破解人机共存密码:人类最后一个大问题》

通用人工智能将是一种适用于所有问题类型的方法,并且在做出很少假设的情况下,它能有效地处理大而难的实例。这就是人工智能研究的终极目标——一个不需要针对具体问题的工程学系统。它会从所有可用的资源中学习它需要学习的东西,在必要时提出问题,并开始制订和执行有效的计划。

Stuart Russell:“通用人工智能可以完成人类能够完成的所有任务。我们希望AGI能够做到人类无法做到的事情。为了研究通用人工智能,我们可以从具体任务的基准 (Benchmarks) 转向任务环境的一般属性,比如部分可观察性、长时程、不可预测性等等,并问自己是否有能力为这些属性提供完整的解决方案。如果我们有这种能力,通用人工智能就应该能够自动地完成人类可以完成的任务,并且还有能力完成更多的任务。”

“Artificial General Intelligence — A gentle introduction” / 中文:“AGI的历史与现状”

“AGI”与“强AI(Strong AI)”、“类人AI(Human-Level AI)”、“完全AI”、“思维机器(Thinking Machine)”、“认知计算(Cognitive Computing)”等概念更加相似。AGI研究包括科学(理论)与工程(技术)两个方面。一个完整的AGI成果通常包括:

1.关于智能的理论

2.该理论的形式化模型

3.该模型的计算机实现

“腾讯研究院:通用人工智能时代科学研究的71个问题”

AI一般可以划分为:

– “狭义人工智能” Artificial Narrow Intelligence(ANI):也被称为弱人工智能,是擅长于单个方面的人工智能,如图像/语音识别系统、AlphaGO等,是在预定的环境中运行、执行特定任务的系统。

-“通用人工智能” Artificial General Intelligence(AGI):也被称为强人工智能,在各方面都能和人类比肩的人工智能,是为了执行广泛的智能任务、抽象思考并适应新环境的系统。Linda Gottfredson教授把智能定义为“一种宽泛的心理能力,能够进行思考、计划、解决问题、抽象思维、理解复杂理念、快速学习和从经验中学习等操作。”强人工智能在进行这些操作时和人类一样得心应手。

– 超人工智能 Artificial Super intelligence(ASI): NickBostrom把超级智能定义为“在几乎所有领域都比最聪明的人类大脑都聪明很多,包括科学创新、通识和社交技能。”

《哥德尔、埃舍尔、巴赫:集异璧之大成 Gödel, Escher, Bach: An Eternal Golden Braid》

CHAPTER XIX Artificial Intelligence: Prospects

Ten Questions and Speculations

Question: Will Al programs ever become “superintelligent”?

Speculation: I don’t know. It is not clear that we would be able to understand or relate to a “superintelligence”, or that the concept even makes sense. For instance, our own intelligence is tied in with our speed of thought. If our reflexes had been ten times faster or slower, we might have developed an entirely different set of concepts with which to describe the world. A creature with a radically different view of the world may simply not have many points of contact with us. I have often wondered if there could be, for instance, pieces of music which are to Bach as Bach is to folk tunes: “Bach squared”, so to speak. And would I be able to understand them? Maybe there is such music around me already, and I just don’t recognize it, just as dogs don’t understand language. The idea of superintelligence is very strange. In any case, I don’t think of it as the aim of Al research, although if we ever do reach the level of human intelligence, superintelligence will undoubtedly be the next goal-not only for us, but for our Al-program colleagues, too, who will be equally curious about Al and superintelligence. It seems quite likely that Al programs will be extremely curious about Al in general-understandably.

智能一般的定义是指解决问题的能力,而问题又可以按照其因果性及是否可重复来进行分类:

1、因果明确,可以重复:简单问题,推理、归纳均有效;如下棋

2、因果明确,不可重复:一般复杂问题,推理有效;如发射火箭

3、因果不明确,可以重复:复杂问题,归纳有效;如量子力学、混沌

4、因果不明确,不可重复:超复杂问题,推理、归纳均无效;如生命的进化

吴伯凡:把问题分为三类

AlphaGo能够打败棋类世界冠军(简单问题),GPT4能够处理大部分的一般复杂问题,AGI能够解决许多复杂问题,而超复杂问题会涉及大量的不可计算函数,是“使生活和数学真理不可预知,留有趣味”的范畴。

2022/06/21

今年高考Ⅰ卷作文题“本手、妙手、俗手”公布后,一众网红纷纷献上”零分”作文。caoz也在其公众号上发表了《妙手,本手,俗手,背后的逻辑是什么》的文章,提出“在AI面前哪有妙手可言”。

人类从大量的对弈过程中总结经验,形成定式、本手、俗手、妙手等概念。AI通过大量经典对局样本或双手互搏不断复盘的深度学习形成决策网络,计算每一步胜率并选择胜率最高的一手,根本不会考虑这一手是俗手还是妙手。“本手、妙手、俗手”等概念是人类计算能力不足时的临时装置,属于思考方法中的“天钩”。由于围棋的计算空间远远大于人脑的思考范围,所以人类必须要使用天钩来分层锚定思维、决策过程。

丹尼尔·丹尼特在《直觉泵和其他思考工具》中对“天钩”有如下定义:

《牛津英语词典》对“天钩”的解释如下:天钩:源自飞行器驾驶员。一种想象中联结至天空的装置;一种想象中悬停在空中的方式。《牛津英语词典》记录该词最早出现于1915年:“一名飞行员被要求停留在原位置(高空处)一小时,飞行员答道:‘飞机未配备天钩。’”拥有天钩可能会是件美事,因为它非常适合在困难的情况下起吊笨重的物体,用以加快各类项目建设。不过,说来让人失望,它们是不可能的。

“本手、妙手、俗手”式的天钩,广泛存在于人类社会中。宗教、哲学等人文领域,由于难以进行量化研究,大量存在“天钩”式的概念、术语。即使科学领域也需要“天钩”来帮助我们思考,是知识增长、进步的必要过程,天文学的发展就是一个范例。“地心说”是基于早期人类大量朴素的天文观察结果而形成的“天钩”,到哥白尼发展出了“日心说”的天钩,再到开普勒的椭圆轨迹修正,然后是牛顿的万有引力、爱因斯坦的相对论。科学正是在不断证伪(或修正)前人天钩、建立新的天钩的基础上发展的。

AI的出现,在围棋这样目标明确(赢棋——比对手多占地盘)、规则清晰的领域,粉碎了人类长期积累出的天钩。2016年AlphaGo战胜李世石,新出现的许多招法颠覆了人们固有的围棋理解和概念,大量的定式甚至棋理都需要推倒重来。

樊麾是第一位与AlphaGo比赛的职业棋手,AlphaGo 5:0完胜。樊麾说:“跟AlphaGo对弈之后,我内心的围棋世界坍塌了。”其后樊麾参加了一项重要的欧洲比赛,加上被AlphaGo沉重打击的内心,他几乎没有信心参赛。“但非常奇怪的事情发生了,我非常轻易的赢了所有的比赛。我和AlphaGo的比赛使我找到了一个新的视角来看我自己的比赛。……如果你想打败大师,你必须忘记你之前学的所有的东西。因为你学的所有东西都像一个笼子一样,把你关在里面。和AlphaGo比完赛后,我建立起了新的东西,现在我下起棋来完全自由了。” 是不是想起了乔帮主的:“Stay hungry,Stay foolish”?

从樊麾的成长过程可以看出,在目标明确、规则清晰的领域,通过AI给出的近似“标准答案”可以帮助人类重新定义概念,梳理思维、决策的层次,建立起新的“天钩”。这也是人类学习、进步所必须经历的过程,通过AI可以加速这一过程,否则就需要等到下一个吴清源的出现,才能带来一些更高层次天钩的突破与创新。

在目标、规则不明确的领域,AI是否可以复现颠覆人类理念的过程(甚至有些人认为的奇点的到来)?

今年2月,Open AI首席科学家萨茨克维尔在社交媒体上称:“现在大型神经网络可能已经有微弱的自主意识了”。最新一波对AI意识觉醒的讨论,是由一名谷歌员工布雷克·莱莫伊引起的。布雷克在谷歌AI伦理部门工作,6月11日公开了一份《LaMDA是有意识的吗?》的文件,详细记述了近大半年来与LaMDA(谷歌2021年在I/O开发者大会上推出的一款专门用于对话的语言模型,能与人类进行符合逻辑常识的高质量交谈)的聊天记录,认为LaMDA已经产生了意识。

英国物理学家霍金、特斯拉创始人马斯克等人也都认为人工智能可以跟人类一样有情感、思维、跨领域思考能力及创造力,未来将对人类造成威胁。

人工智能不同于人类以生存发展为目标(人类是否是这个目标、是否有目标等问题还在争论探讨中),深度学习是针对某类人为给定的目标和大数据样本,实现最佳化的过程,现阶段的AI本身还没有生存的概念。除了经过一个较长期的,与环境、种群间生存竞争的过程,还看不到其他的使AI能够成为具有自主目标的实体的方式。即使未来某些AI能够通过某次图灵测试,也只是它的经过训练的计算系统对输入的直接反馈。由于AI的深度学习及决策的许多过程、结果都具有黑箱的属性,往往会被解释为呈现出人格、情绪等特点(人们有拟人化解释物体行为的倾向),并不等于AI具有了独立意识。

AI作为智能工具实现人类赋予的任务目标,能够取代大量相对重复性高的工作(即爱迪生说的“99%的汗水”的部分,但那1%的灵感在目标、规则不明确的领域还是需要人类来完成)。AI会在这些领域给人类带来巨大影响,在取得丰富成果的同时,给某些人群的冲击可能会比工业革命还剧烈。

AI成为主脑科学家(AI-masterbrain Research):AI介导的五阶段科学革命(The Five Stages of AI-involved Scientific Revolution)

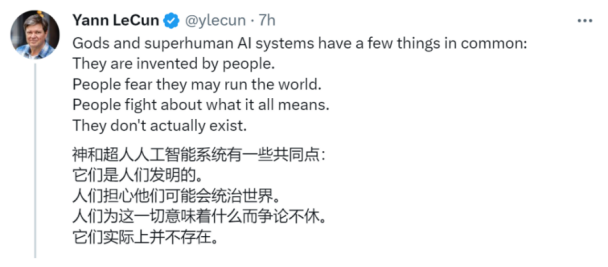

LeCun:AI将带来人类的新文艺复兴,一种新的启蒙运动,因为AI将放大每个人的智力。这就像每个人都有一群比自己更聪明,对大多数话题都更加熟悉的人在帮助自己。它将赋予我们每个人更大的权力。

ChatGPT不会拥有人类的创造力,没有意识和动机,即使他学会了推理,但AI以他不断进化的能力,帮助人们拓展文明的边界,帮助人们抵达文明新的高度。物理学家大卫·布儒斯特,他在目睹了国际象棋机器人及其引起的科学探索之后,说了一句意味深长的话:“那些本来为了取悦普通人而发明出来的自动化玩具,现在正在用于开拓我们人类的能力并将文明带向更新的境界。”